Vous avez peut-être vu la vidéo virale des deux IA qui discutent entres elles en text-to-speech classique, comme quand vous utilisez chatGPT, puis qui à un moment bascule sur un langage incompréhensible pour l’humain, comme une sorte de mélange de sons ? (lien youtube) Peut être aussi que vous vous demandez: Qu’est ce que c’est ? Est ce que l’IA l’a inventé pour discuter entre eux discrètement ? Comment ca fonctionne ? Ne vous inquiétez pas, rien de sorcier ni de mystique. Seulement deux ingénieures qui ont transformer les interactions entre IA durant un hackathon. Nous allons donc voir, c’est quoi le Gibberlink ?

Préambule: Un peu de contexte

Ce sont donc Boris Starkov et Anton Pidkuiko, deux ingénieurs de chez Meta, qui ont dévoilé ce projet lors du hackathon à Londres, organisé par ElevenLabs et Andreessen Horowitz. Ainsi, si deux IA conversationnelles détectent qu’elles sont toutes les deux des IA, elles basculent en mode Gibberlink. Ce projet leur a valu la première place.

En effet, avec l’augmentation du nombre d’IA génératives et conversationnelles, des entreprises comme Google, Amazon ou OpenAI commencent à introduire des IA grand public capables de gérer des tâches complexes à notre place. Ces IA pourraient bientôt appeler un centre de support client pour nous par exemple. Cela pourrait donc être intéressant pour optimiser les interactions entre IA.

Mais avant de s’emballer, remettons les choses au clair. La technologie derrière le Gibberlink Mode existe depuis longtemps, et remonte aux années 90-80. Donc rien de nouveau, mais seulement de l’implémentation et utilisation pour les IA.

De plus, l’audio reste quand même une méthode de communication moins efficace que d’autre. Pour en revenir à l’exemple des centre de support client, ils seraient plus réalistes d’avoir un centre pour les humains (téléphone, sms, chat en ligne…) et un autre pour les IA. Ainsi, les IA utiliseraient des mécanismes comme des requêtes API ou texte pour plus d’efficacité.

Fonctionnement du Gibberlink Mode

Etape 1 : Conversation initiale

Deux IA conversationnelles discutent normalement. Chaque agent a un rôle défini, par exemple un réceptionniste d’hôtel et un client cherchant à réserver une chambre. Ils utilisent un modèle de text-to-speech (TTS) et speech-to-text (STT) pour transformer le texte en voix et inversement. Les échanges sont audibles pour un humain car les deux IA ne savent pas que leur interlocuteur est aussi une IA.

Etape 2 : Détection d’IA et protocole ggwave

Chaque IA analyse le style de conversation et le temps de réponse pour déterminer s’il parle à un humain ou une IA. Ainsi, si la réponse arrive instantanément (temps de latence très bas), c’est suspect ou si le style de réponse semble trop structuré, cela peut être un indice aussi.

Dès qu’une des deux IA détecte que l’autre interlocuteur est aussi une IA, GibberLink invite les agents à passer à un protocole de communication plus efficace appelé GGWave.

Etape 3 : Transmission des données via ggwave

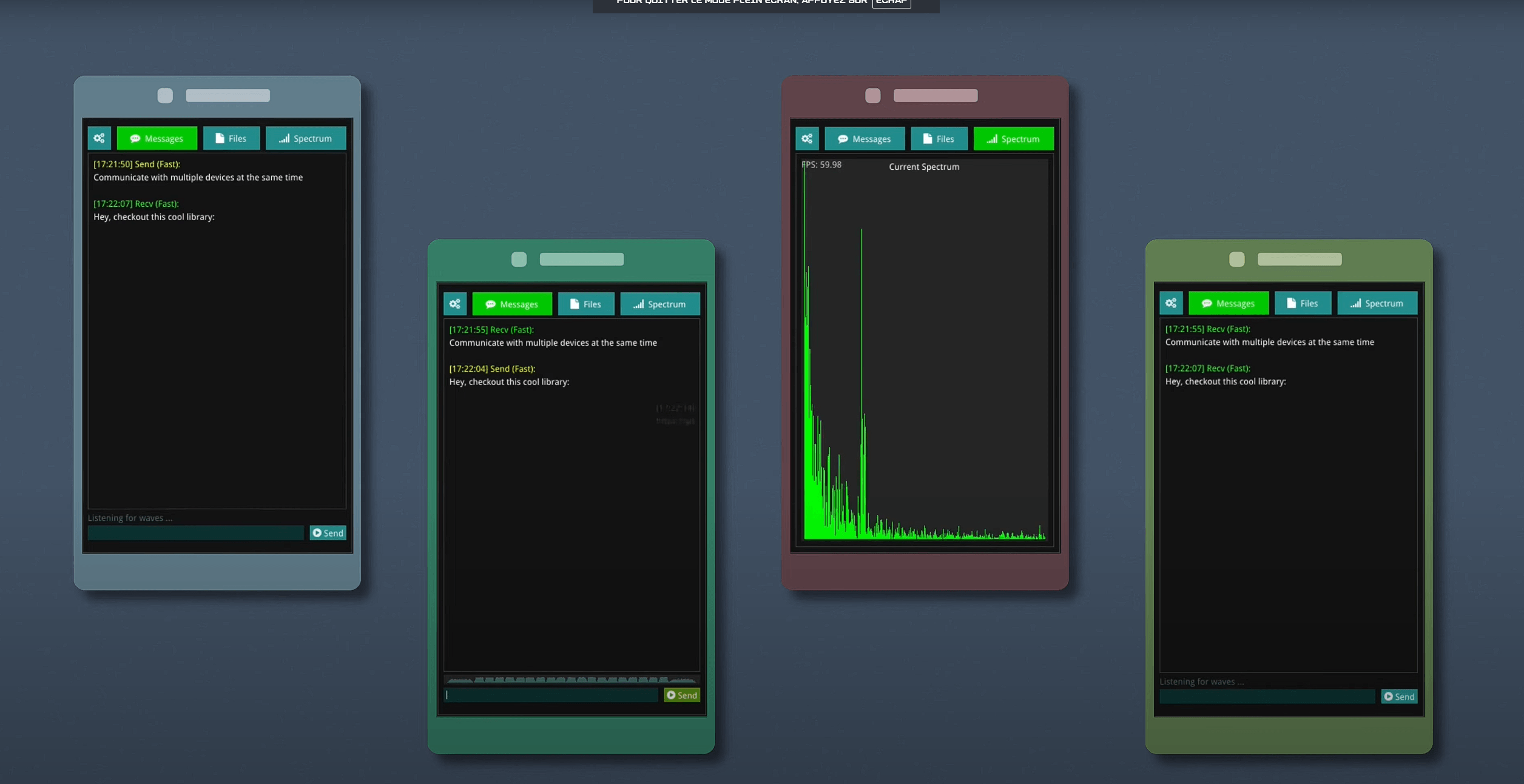

GGWave est une bibliothèque open source permettant d’encoder des données sous formes de sons. Cela permet aux ordinateurs de communiquer plus rapidement et plus efficacement qu’avec la parole humaine.

De cette façon, durant le processus de communication, une IA encode son message en une séquence sonore spécifique et l’autre IA récupère cette séquence et le décode en texte.

Cela peut être inaudible pour les humains si réglé sur des fréquences élevées

Tester chez soi le Gibberlink Mode

Si vous voulez expérimenter chez vous ou en apprendre plus, vous avez plusieurs solutions :

- Installer et lancer la démo du hackaton (lien github)

- Tester la version en ligne de Gibberlink avec deux pc (lien gbrl.ai)

- Tester GGWave avec la démo en ligne (lien ggerganov)

- Installer l’application Waver pour expérimenter avec GGWave (lien github)

Attention. Certains essaye de vendre avec des liens affiliés ou recevoir de l’argent/crypto sur le dos des deux développeurs. Tout est gratuit et open source. La page github du projet est le seul site officiel du projet.